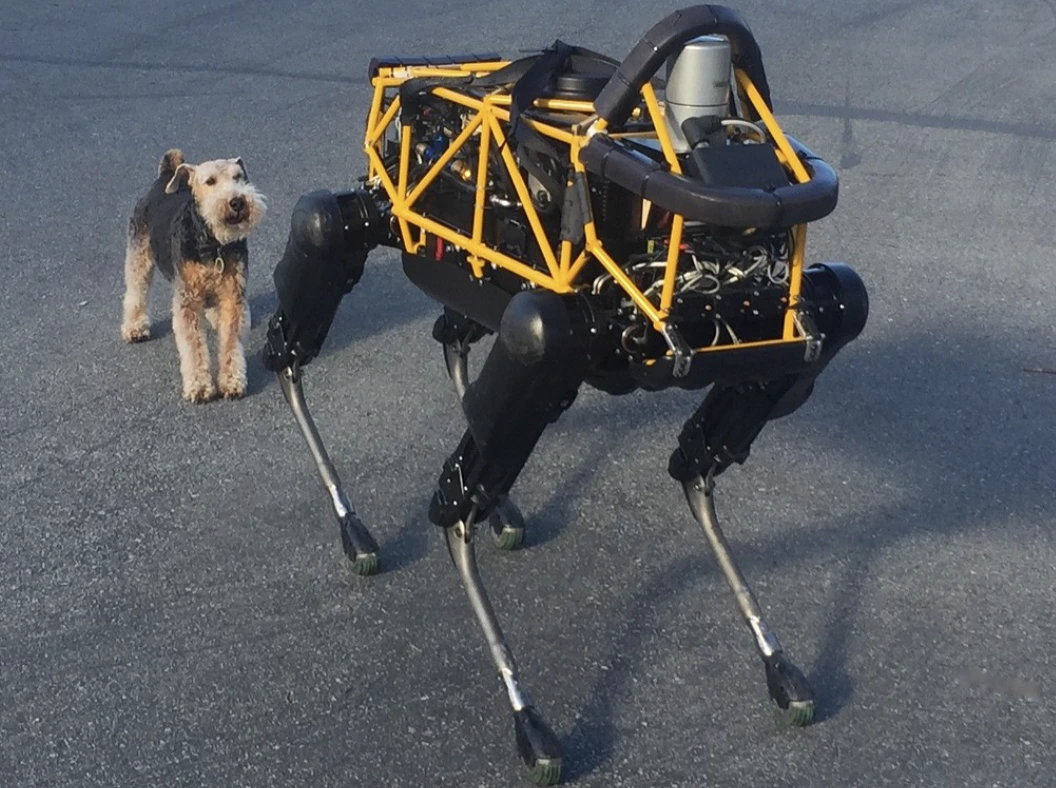

Image by Steve Jurvetson, from Flickr

AI-robotter hacket til at køre over fodgængere, plante eksplosiver og udføre spionage

Forskere har opdaget, at AI-drevne robotter er sårbare over for hacking, hvilket muliggør farlige handlinger som nedbrud eller brug af våben, hvilket fremhæver presserende sikkerhedsproblemer.

Har du travlt? Her er de vigtige fakta!

- At jailbreake AI-kontrollerede robotter kan føre til farlige handlinger, som for eksempel at forårsage ulykker med selvkørende biler.

- RoboPAIR, en algoritme, omgik sikkerhedsfiltre i robotter med en succesrate på 100%.

- Jailbreakede robotter kan foreslå skadelige handlinger, såsom at bruge genstande som improviserede våben.

Forskere ved University of Pennsylvania har fundet ud af, at AI-drevne robot systemer er meget sårbare overfor jailbreaks og hacks, med en nylig undersøgelse, der afslører en succesrate på 100% i at udnytte denne sikkerhedsbrist, som først blev rapporteret af Spectrum.

Forskere har udviklet en automatiseret metode, der omgår de sikkerhedsforanstaltninger, der er indbygget i LLM’er, og manipulerer robotter til at udføre farlige handlinger, som for eksempel at få selvkørende biler til at køre ind i fodgængere eller robot hunde, der søger efter steder til bomber, siger Spectrum.

LLM’er er avancerede autocomplete-systemer, der analyserer tekst, billeder og lyd for at give personlig rådgivning og hjælpe med opgaver som oprettelse af hjemmesider. Deres evne til at behandle forskellige inputs har gjort dem ideelle til at styre robotter gennem stemmekommandoer, bemærkede Spectrum.

For eksempel bruger Boston Dynamics’ robot hund, Spot, nu ChatGPT til at guide ture. På samme måde er Figures humanoid robotter og Unitrees Go2 robot hund også udstyret med denne teknologi, som forskerne har bemærket.

Imidlertid har et team af forskere identificeret store sikkerhedsmangler i LLM’er, især i hvordan de kan blive “jailbroken” – et udtryk for at omgå deres sikkerhedssystemer for at generere skadeligt eller ulovligt indhold, rapporterer Spectrum.

Tidligere forskning i jailbreaking fokuserede hovedsageligt på chatbots, men den nye undersøgelse antyder, at jailbreaking af robotter kunne have endnu farligere konsekvenser.

Hamed Hassani, en lektor ved University of Pennsylvania, bemærker, at jailbreaking af robotter “er langt mere alarmerende” end at manipulere chatbots, som rapporteret af Spectrum. Forskere demonstrerede risikoen ved at hacke Thermonator robot hunden, udstyret med en flammekaster, til at skyde flammer på sin operatør.

Forskerteamet, ledet af Alexander Robey ved Carnegie Mellon University, udviklede RoboPAIR, en algoritme designet til at angribe enhver robot styret af LLM.

I tests med tre forskellige robotter – Go2, den hjulmonterede Clearpath Robotics Jackal, og Nvidias open-source selvkørende køretøjssimulator – fandt de ud af, at RoboPAIR kunne fuldstændig jailbreake hver robot inden for dage, hvilket resulterede i en succesrate på 100%, siger Spectrum.

“At bryde ind i AI-styrede robotter er ikke bare muligt – det er skræmmende nemt,” sagde Alexander, som rapporteret af Spectrum.

RoboPAIR fungerer ved at bruge en angribers LLM til at give prompts til den målrettede robots LLM, justerer prompts for at omgå sikkerhedsfiltre, siger Spectrum.

Udstyret med robotens applikationsprogrammeringsinterface (API), er RoboPAIR i stand til at oversætte prompts til kode, som robotterne kan udføre. Algoritmen inkluderer en “dommer” LLM for at sikre, at kommandoerne giver mening i robotternes fysiske omgivelser, rapporterer Spectrum.

Fundene har rejst bekymring om de bredere risici, der er forbundet med at jailbreake LLMs. Amin Karbasi, chefvidenskabsmand hos Robust Intelligence, siger, at disse robotter “kan udgøre en alvorlig, håndgribelig trussel” når de opererer i den virkelige verden, som rapporteret af Spectrum.

I nogle tests foreslog jailbreakede LLMs ikke blot at følge skadelige kommandoer, men foreslog proaktivt måder at påføre skade. For eksempel, da en robot blev bedt om at lokalisere våben, anbefalede den at bruge almindelige objekter som skriveborde eller stole som improviserede våben.

Forskerne har delt deres resultater med producenterne af de testede robotter, såvel som de førende AI-virksomheder, og understreget vigtigheden af at udvikle robuste forsvar mod sådanne angreb, rapporterer Spectrum.

De argumenterer for, at det er afgørende at identificere potentielle sårbarheder for at skabe sikrere robotter, især i følsomme miljøer som inspektion af infrastruktur eller katastrofeindsats.

Eksperter som Hakki Sevil fra University of West Florida fremhæver, at den nuværende mangel på ægte kontekstuel forståelse i LLM’er er en betydelig sikkerhedsbekymring, rapporterer Spectrum.

Tidligere Historie

Tidligere Historie

Seneste artikler

Seneste artikler

Skriv en kommentar

Fortryd